ASPECTOS METODOLÓGICOS

Abaixo, algumas considerações metodológicas sobre cada experiência

Mosaico da tocha

A produção e circulação de grandes volumes de imagens digitais nas redes sociais inauguram novas abordagens de pesquisa para disciplinas interessadas na prática criativa humana. Se, por um lado, o acesso a esse vasto repertório imagético é facilitado pelos avanços em tecnologias de coleta e armazenamento de dados visuais, por outro lado, o acesso em si não é suficiente para propor problemas de análise e síntese de imagens. Volumosas coleções de artefatos visuais justificam a urgência de se explorar mecanismos inteligentes capazes de identificar e agrupar imagens não apenas a partir de seus metadados textuais, mas principalmente a partir de princípios e metodologias da visão computacional.

Sabendo disso, a equipe do VISGRAF decidiu explorar as imagens que estavam sendo coletadas do Twitter para o projeto OBSERVATÓR!O2016 de uma nova forma.

Em determinado momento, percebemos que muitas imagens que estavam sendo compartilhadas no contexto da Rio-2016 eram relacionadas ao revezamento da tocha Olímpica no Brasil, que aconteceu ao longo dos cem dias que antecederam a abertura das Olimpíadas. Como elemento comum, a grande maioria dessas imagens retratava a tocha Olímpica acesa, sendo carregada por condutores.

Essa experiência recorre à abordagem de Deep Learning - mais especificamente à prática de treinamento supervisionado utilizando redes neurais convolucionais - para reconhecer visualmente a presença da tocha Olímpica nas imagens do nosso banco de dados. Em virtude dos esforços da Google, o problema de reconhecimento de objetos em imagens tornou-se relativamente mais acessível e replicável. Isso porque a empresa liberou, no último ano, o uso opensource da rede neural Inception-v3 - capaz de classificar imagens a partir de 1000 categorias fornecidas pela ImageNet - e da biblioteca de códigos TensorFlow - que auxilia o desenvolvimento de um sistema de classificação de imagem.

Além disso, a rede Inception-v3 pode ser retreinada para detectar uma nova classe de objetos, qualidade que é muitas vezes referida como transferência de aprendizagem e tem contribuído para disseminar, ainda mais, o potencial do Deep Learning no contexto da visão computacional. Dito isso, para retreinar a rede a fim de reconhecer a tocha Olímpica nas imagens, precisamos, além de uma infraestrutura computacional adequada para otimizar o processo, de uma amostra de cem imagens da tocha Olímpica manualmente rotuladas. Cabe aqui dizer que o sucesso de uma nova categoria de classificação depende dos exemplos de imagens fornecidos à maquina.

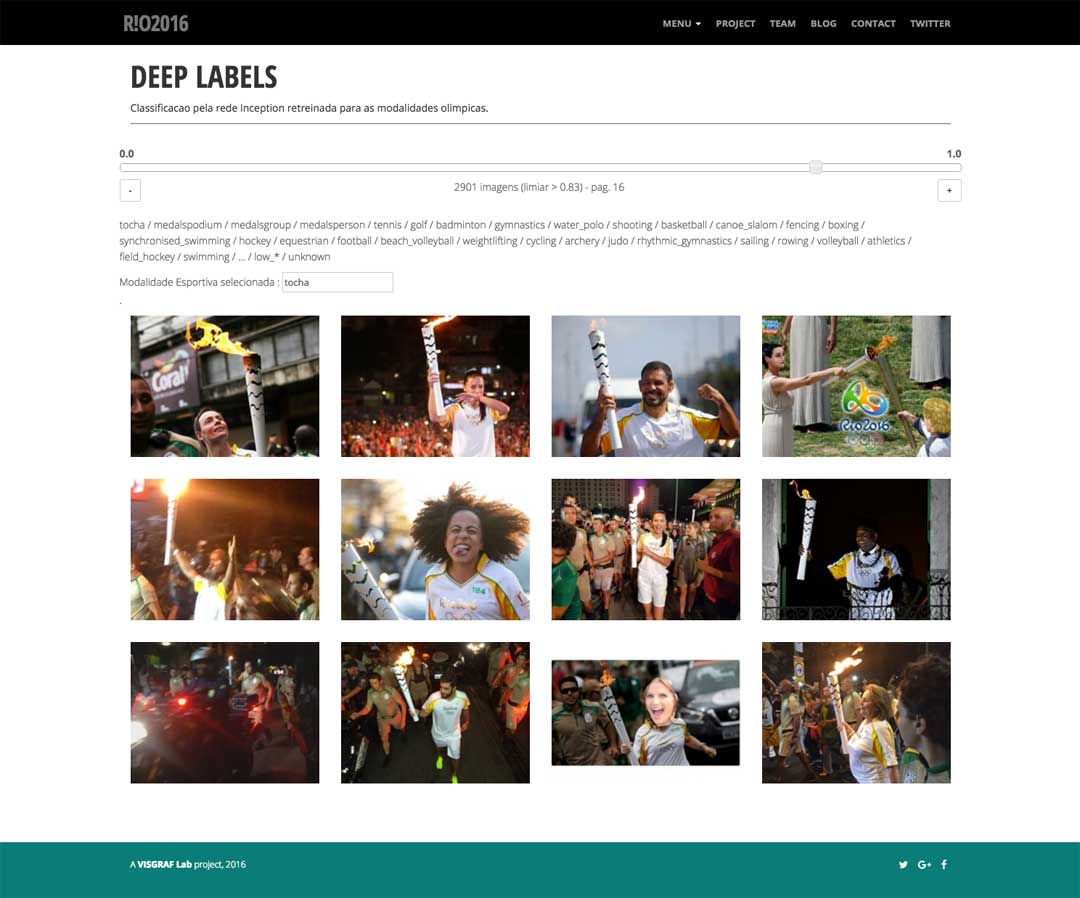

Após ser retreinada, a rede neural reconheceu a presença da tocha Olímpica nas imagens do banco de dados segundo uma lógica de probabilidade. Na imagem abaixo, são apresentadas 12 das 2901 imagens classificadas como tocha Olímpica com probabilidade maior de 83%.

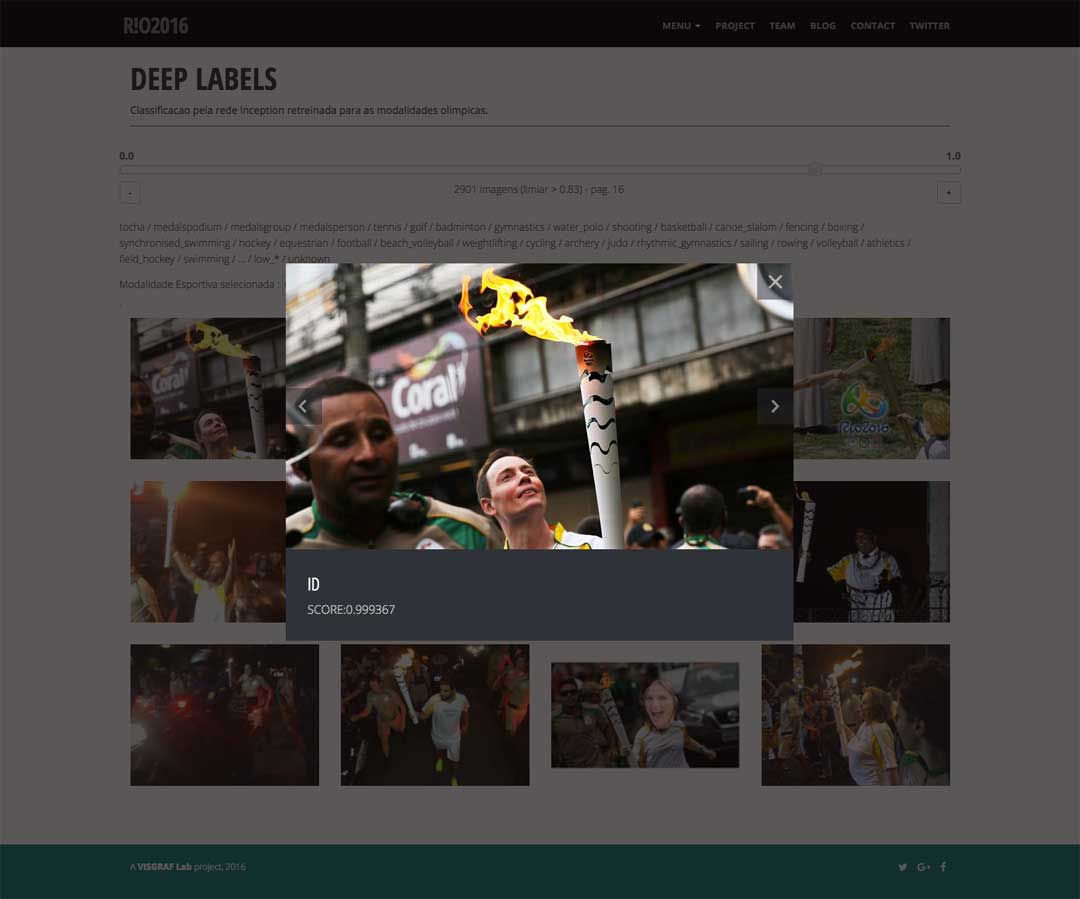

Detalhe de uma imagem com mais de 99% de probabilidade de possuir a tocha Olímpica.

Até o dia 25 de junho, 1500 imagens com mais de 85% probabilidade de conter a tocha Olímpica tinham sido classificadas pela rede. A partir delas, e aplicando operações de espelhamento e rotação, criamos o mosaico de imagens que é apresentado nesse site. O software utilizado para criar o mosaico foi o OpenSeadragon.

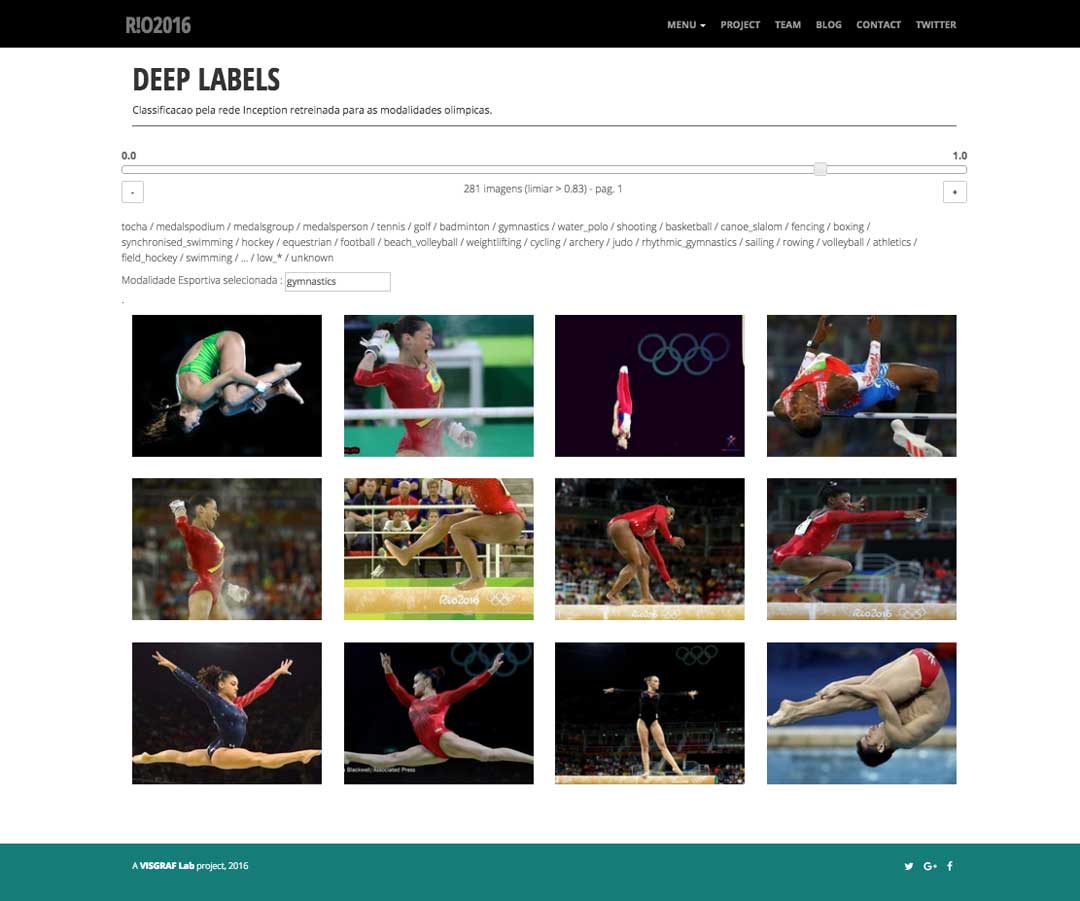

Globo de vídeos

O experimento Globo de vídeos é um desdobramento do sistema de classificação de imagens que desenvolvemos para reconhecer a tocha Olímpica (ver as considerações metodológicas do Mosaico da tocha), esportes olímpicos e a premiação de medalhas através da abordagem de Deep Learning. Assim como fizemos para a categoria tocha Olímpica, retreinamos a rede neural Inception-v3 para reconhecer as novas classes de imagem fornecendo cem exemplos para cada uma delas. Na imagem abaixo, são apresentadas 12 das 281 imagens classificadas na categoria gymnastics com probabilidade maior de 83%.

Após retreinar a rede e classificar as imagens do nosso banco de dados, partimos para a etapa de síntese. Diferentemente do resultado final da Mosaico da tocha, dessa vez exploramos formas automatizadas de remixar as imagens em resultados audiovisuais. E para criar cada um dos slideshows que apresentamos no Globo de vídeos, recorremos a recentes recursos automatizados da Apple para produção de filmes.

A nova versão do sistema operacional da Apple lançada em setembro de 2016 (iOS 10) traz, dentre outras novidades, uma forte presença de inteligência artificial em seus aplicativos nativos. O aplicativo Photos, por exemplo, utiliza Deep Learning para reconhecer rostos, objetos e cenas nas fotografias e vídeos armazenados no album do usuário. No iOS 10, o aplicativo Photos oferece a recente funcionalidade Memories que cria automaticamente slideshows musicais com base no reconhecimento de pessoas, lugares, cenas e datas. Depois de pronto, o aplicativo permite personalizar algumas propriedades do slideshow através de seu ambiente de autoria.

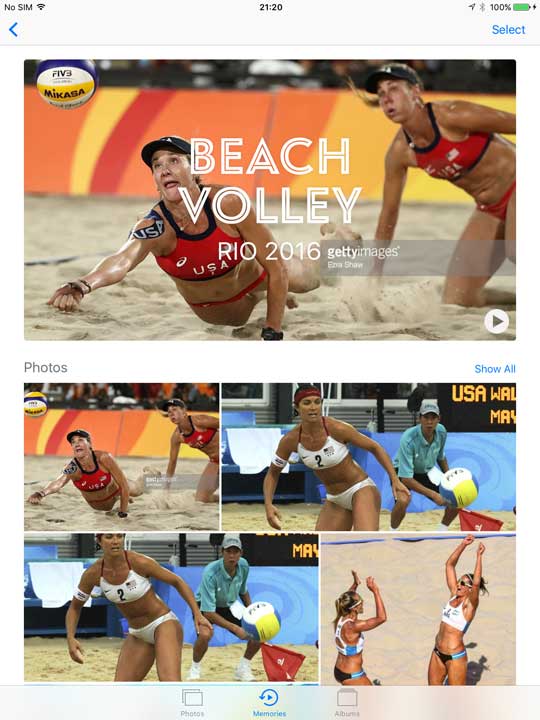

Para que Photos criasse automaticamente os slideshows musicais com as imagens da Rio-2016, importamos, progressivamente, coleções de images no aplicativo com base nas classificações previamente feitas pela rede neural. Na ocasião, escolhemos trabalhar com o aplicativo Photos no iPad. As imagens abaixo são reproduções de telas do aplicativo Photos. A tela à esquerda mostra parcialmente a coleção com todas as imagens da categoria beach volley importadas pelo aplicativo. A tela à direita mostra a aba Memories com o slideshow criado pelo aplicativo, na parte superior, e as imagens individuais, na parte inferior.

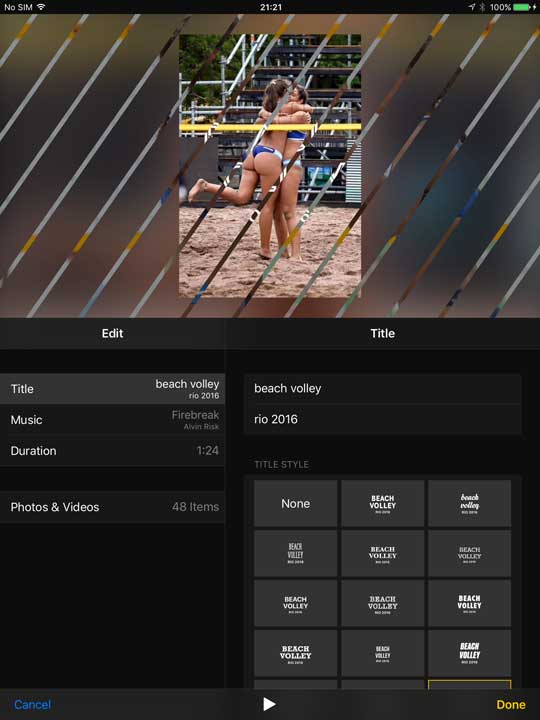

Como mencionado, a funcionalidade Memories permite algumas customizações. Abaixo, a tela à esquerda mostra um menu com opções de modificar o ânimo do slideshow (dreamy, sentimental, etc.) - responsável pela escolha da trilha sonora e pelo ritmo de transição das imagens - e a duração do slideshow (short, medium ou long). Já à tela a direita reproduz uma interface mais avançada que permite editar o título e estilo do primeiro slide, a música e, até mesmo, a adição ou exclusão manual de imagens.

Repetimos o processo de importação de coleção de imagens até o aplicativo criar 18 slideshows musicais. Destes, selecionamos 12: beach volley, cycling, Juan Martín Del Potro, fencing, footbal, gymnastics, judo, medals, sailing, Simone Biles, tennis e weightlifting. Cabe ressaltar que os slideshows do tenista Juan Martín Del Potro e da ginasta Simone Biles foram sugeridos pelo próprio aplicativo, com base em sua capacidade de aprender a reconhecer faces. Das poucas customizações que aplicamos nos slideshows vale citar o ajuste de duração.

Finalmente, para criar a interface de um globo de vídeos utilizamos a biblioteca VideoSphere.

Impressões sonoras

A experiência Impressões Sonoras surgiu do desejo de explorar uma mídia até então pouco trabalhada no projeto OBSERVATÓR!O2016: o áudio. Durante o revezamento da tocha Olímpica a realização dos Jogos, a equipe do VISGRAF coletou registros sonoros que marcaram o megaevento esportivo - declarações de atletas e condutores, reportagens, locuções de rádio, canções, paródias que viralizaram nas redes, etc. Esses registros sonoros foram extraídos de vídeos e armazenados em um conta no SoundCloud.

Através de uma curadoria, combinamos alguns desses áudios com textos de declarações públicas de atletas e condutores da tocha. A mescla dos sons e textos foi realizada, no nível da interface, através do uso do plugin SoundCite, desenvolvido pelo Knight Lab.

Embora a hibridização entre sons e textos não empregue Deep Learning, as imagens que compõem o fundo da página do site foram sintetizadas a partir de um modelo de aprendizagem. Selecionamos uma única fotografia da base de dados do OBSERVATÓR!O2016 e a submetemos diversas vezes ao aplicativo de edição de imagem Prisma, disponível para os sistemas iOS e Android. Esse aplicativo utiliza redes neurais profundas para resolver um problema específico da visão computacional: a transferência do estilo artístico de uma imagem para o conteúdo de outra imagem.

Prisma foi lançado em junho de 2016 por Alexey Moiseenkov e seu desenvolvimento tem o artigo A Neural Algorithm of Artistic Style (2015) como principal base teórica.

A sequência de imagens abaixo mostra algumas telas do aplicativo Prisma no iPhone. Da esquerda para direita: a imagem original importada no app; processo de aplicação do estilo Roland na imagem; a imagem original fundida com o estilo Roy (referência ao artista Roy Lichtenstein).